Применение инструментов Big Data и Machine Learning в IoT

Учитывая сложность и разнообразность данных, генерируемых разнородными устройствами и датчиками, остро встает вопрос автоматизации их управления и анализа. Автоматизированное выявление зависимостей и построение взаимосвязей между устройствами – это новый вызов для дальнейшего развития IoT. Именно поэтому IoT становится технологией, которую сложно представить без инструментов машинного обучения (Machine Learning). Благодаря им появляется возможность построения профилей поведения устройств в сети и выявления скрытых взаимосвязей между ними, что, в свою очередь, несет новые возможности автоматизации управления устройствами и предиктивной аналитики.

Концепция IoT зарождалась и развивалась как вполне самостоятельная идея, заключающаяся в объединении большого числа физических устройств, поддерживающих интерфейсы взаимодействия друг с другом и внешней средой в единой вычислительной сети. Однако, учитывая стремительные темпы роста популярности и востребованности данной концепции на рынке, число устройств в подобных сетях растет настолько быстро, что традиционная архитектура становится малоэффективной и сложно реализуемой.

Концепция IoT на текущий момент находится на том этапе, когда интеграция со вспомогательными технологиями и инструментами является необходимым логическим шагом к дальнейшему развитию.

Рассмотрим фундаментальные проблемы IoT-архитектур без технологий Big Data и инструментов ML:

- разнообразие устройств и датчиков. IoT-системы состоят из большого числа устройств, имеющих разные стандарты и интерфейсы взаимодействия и, как следствие, генерируют разнородные данные;

- отсутствие адаптивного контроля и управления устройствами. Разные стандарты взаимодействия и территориальная распределенность порождают сложности в эффективном менеджменте данных устройств;

- сложность сбора и обработки данных с различных устройств. Проблемы заключается не только в объемах данных, но и в их разнородности – различных протоколах, форматах и изменяющихся адресах целевых источников;

- масштабируемость, сложность хранения больших объемов данных, производительность. В современных условиях цифровизации объем данных и их эффективное хранение – это настоящий вызов;

- постоянно растущая сеть IoT-устройств и сложность автоматизированного построения новых взаимосвязей. Для возможности гибкого добавления новых и удаления старых устройств необходимы инструменты построения и поддержания в актуальном состоянии топологии сети.

Вышеперечисленные проблемы формируют серьезный барьер для дальнейшего развития IoT-систем, преодолеть который возможно с помощью внедрения инструментов машинного обучения, а также технологий работы с большими данными.

IoT-архитектура без/с алгоритмами Machine Learning и технологиями Big Data

Чтобы понять, как Machine Learning и Big Data могут повысить эффективность работы IoT, стоит взглянуть на принципиальные различия архитектур IoT-систем, которые следуют традиционной концепции, и систем, использующих инструменты для работы с большими данными и машинное обучение.

Типовая архитектура IoT без машинного обучения включает в себя четыре основных блока (см. схему 1):

- интернет-вещи – умные устройства, датчики и сенсоры;

- шлюзы, использующие промышленные протоколы связи и располагающиеся относительно близко к конечным устройствам;

- централизованное хранилище данных – ЦХОД и облачные хранилища;

- конечные устройства, с которыми взаимодействуют пользователи – исследуют данные и получают уведомления.

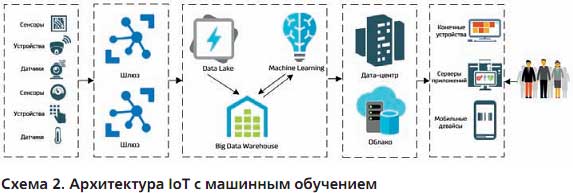

В архитектуре IoT, применяющей инструменты для работы с большими данными и алгоритмы машинного обучения, присутствует дополнительный, но очень важный блок (см. схему 2).

В ней повышается качество данных, а следовательно и качество принимаемых решений и уведомлений, генерируемых системой. Кроме того, за счет адаптивной приоритизации и фильтрации данных существенно снижаются затраты на хранение данных в ЦХОД и облачных хранилищах.

Machine Learning & IoT: реализованные кейсы

Лучше всего преимущества и эффективность применения инструментов машинного обучения и технологий Big Data при построении IoT-систем демонстрируют практические сценарии использования. Ниже приведены несколько Use Cases, в которых благодаря современным инструментам для работы с данными IoT-система сделала значительный шаг вперед.

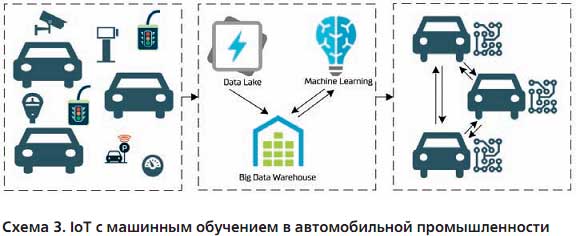

Tesla Motors. Автомобили Tesla – это «вещи», использующие множество других интернет-вещей, которые благодаря Machine Learning позволяют из «вещи» сделать мощный искусственный интеллект. Помимо Tesla, другие крупные автомобильные компании также используют концепцию IoT, однако без современных инструментов для работы с данными. Для того чтобы понять, чем же Tesla так сильно отличается от всех остальных, достаточно цитаты Илона Маска из недавнего интервью: «Все автомобили в Tesla работают как единая сеть. Когда одна машина учится чему-то, этому учатся и все остальные. Это выходит за рамки того, что делают другие автомобильные компании». Таким образом, каждая ситуация на дороге – это новый опыт для автомобиля, который он обязательно учтет в следующей поездке и передаст своим «коллегам» (см. схему 3).

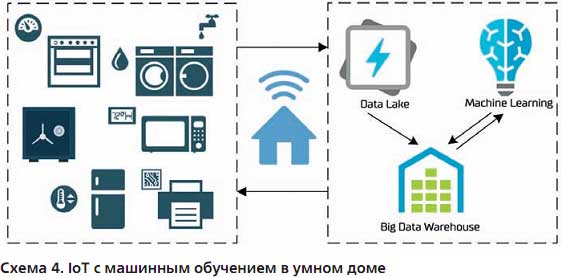

Nest. Термин «умный дом», наверное, слышал каждый. Однако у компании Nest, которую недавно приобрела корпорация Google за $3,2 млрд, получилось сделать дом действительно умным. Искусственный интеллект Nest анализирует график работы пользователей, их температурные и прочие предпочтения. Благодаря этому системе удается сократить затраты на потребление энергии и повысить комфорт за счет адаптации системы под конкретного пользователя (см. схему 4).

IoT-платформы. Стоит упомянуть не только конкретные сценарии использования IoT с Machine Learning, но и взглянуть на то, как развиваются передовые IoT-платформы, такие как Google Cloud IoT и AWS IoT. Они позволяют интегрировать IoT-устройства с моделями машинного обучения и решать сложные комплексные задачи. Сервис AWS IoT Greengrass ML Inference может локально формировать на устройствах логические выводы с использованием машинного обучения, применяя модели, созданные, обученные и оптимизированные в облаке. Так, в SageMaker можно создать прогнозирующую модель для анализа видеозаписей, оптимизировать ее для работы на камерах, которые смогут самостоятельно выявлять подозрительную активность и отправлять уведомления об этом. Например, при обнаружении нелегитимной активности около банковского терминала умная камера сама определит, что злоумышленник планирует взлом, и предиктивно вызовет наряд полиции. Данные, полученные с помощью логических выводов на IoT Greengrass, можно отправить обратно в SageMaker, где они обогащаются индикаторами и используются для непрерывного повышения качества моделей машинного обучения.

Будущее наступило

В современном мире в силу постоянно растущего количества умных устройств и объема данных, генерируемых ими, индустрия IoT уже не может существовать без инструментов для работы с большими данными и машинного обучения. Яркие примеры компаний, использующих Machine Learning в IoT-архитектурах, и векторы развития актуальных IoT-платформ демонстрируют нам очевидные преимущества данного подхода. Для эффективной работы современных IoT-систем жизненно необходима интеграция с сторонними продуктами, реализующими соответствующий функционал.

Big Data и блокчейн — прорыв в области анализа данных

Постоянное ускорение роста объема данных является неотъемлемым элементом современных реалий. Социальные сети, мобильные устройства, данные с измерительных устройств, бизнес-информация – это лишь несколько видов источников, способных генерировать гигантские массивы данных.

В настоящее время термин Big Data (Большие данные) стал довольно распространенным. Далеко не все еще осознают то, насколько быстро и глубоко технологии обработки больших массивов данных меняют самые различные аспекты жизни общества. Перемены происходят в различных сферах, порождая новые проблемы и вызовы, в том числе и в сфере информационной безопасности, где на первом плане должны находиться такие важнейшие ее аспекты, как конфиденциальность, целостность, доступность и т. д.

К сожалению, многие современные компании прибегают к технологии Big Data, не создавая для этого надлежащей инфраструктуры, которая смогла бы обеспечить надежное хранение огромных массивов данных, которые они собирают и хранят. С другой стороны, в настоящее время стремительно развивается технология блокчейн, которая призвана решить эту и многие другие проблемы.

Что такое Big Data?

По сути, определение термина лежит на поверхности: «большие данные» означают управление очень большими объемами данных, а также их анализ. Если смотреть шире, то это информация, которая не поддается обработке классическими способами по причине ее больших объемов.

Сам термин Big Data (большие данные) появился относительно недавно. Согласно данным сервиса Google Trends, активный рост популярности термина приходится на конец 2011 года:

В 2010 году уже стали появляться первые продукты и решения, непосредственно связанные с обработкой больших данных. К 2011 году большинство крупнейших IT-компаний, включая IBM, Oracle, Microsoft и Hewlett-Packard, активно используют термин Big Data в своих деловых стратегиях. Постепенно аналитики рынка информационных технологий начинают активные исследования данной концепции.

В настоящее время этот термин приобрел значительную популярность и активно используется в самых различных сферах. Однако нельзя с уверенностью сказать, что Big Data – это какое-то принципиально новое явление – напротив, большие источники данных существуют уже много лет. В маркетинге ими можно назвать базы данных по покупкам клиентов, кредитным историям, образу жизни и т. д. На протяжении многих лет аналитики использовали эти данные, чтобы помогать компаниям прогнозировать будущие потребности клиентов, оценивать риски, формировать потребительские предпочтения и т. д.

В настоящее время ситуация изменилась в двух аспектах:

— появились более сложные инструменты и методы для анализа и сопоставления различных наборов данных;

— инструменты анализа дополнились множеством новых источников данных, что обусловлено повсеместным переходом на цифровые технологии, а также новыми методами сбора и измерения данных.

Исследователи прогнозируют, что технологии Big Data активнее всего будут использоваться в производстве, здравоохранении, торговле, госуправлении и в других самых различных сферах и отраслях.

Big Data – это не какой-либо определенный массив данных, а совокупность методов их обработки. Определяющей характеристикой для больших данных является не только их объем, но также и другие категории, характеризующие трудоемкие процессы обработки и анализа данных.

В качестве исходных данных для обработки могут выступать, например:

— логи поведения интернет-пользователей;

— Интернет вещей;

— социальные медиа;

— метеорологические данные;

— оцифрованные книги крупнейших библиотек;

— GPS-сигналы из транспортных средств;

— информация о транзакциях клиентов банков;

— данные о местонахождении абонентов мобильных сетей;

— информация о покупках в крупных ритейл-сетях и т.д.

Со временем объемы данных и количество их источников непрерывно растет, а на этом фоне появляются новые и совершенствуются уже имеющиеся методы обработки информации.

Основные принципы Big Data:

— Горизонтальная масштабируемость – массивы данных могут быть огромными и это значит, что система обработки больших данных должна динамично расширяться при увеличении их объемов.

— Отказоустойчивость – даже при сбое некоторых элементов оборудования, вся система должна оставаться работоспособной.

— Локальность данных. В больших распределенных системах данные обычно распределяются по значительному числу машин. Однако по мере возможности и в целях экономии ресурсов данные часто обрабатываются на том же сервере, что и хранятся.

Для стабильной работы всех трех принципов и, соответственно, высокой эффективности хранения и обработки больших данных необходимы новые прорывные технологии, такие как, например, блокчейн.

Для чего нужны большие данные?

Сфера применения Big Data постоянно расширяется:

— Большие данные можно использовать в медицине. Так, устанавливать диагноз пациенту можно не только опираясь на данные анализа истории болезни, но также принимая во внимание опыт других врачей, сведения об экологической ситуации района проживания больного и многие другие факторы.

— Технологии Big Data могут использоваться для организации движения беспилотного транспорта.

— Обрабатывая большие массивы данных можно распознавать лица на фото- и видеоматериалах.

— Технологии Big Data могут быть использованы ритейлерами – торговые компании могут активно использовать массивы данных из социальных сетей для эффективной настройки своих рекламных кампаний, которые могут быть максимально ориентированы под тот или иной потребительский сегмент.

— Данная технология активно используется при организации предвыборных кампаний, в том числе для анализа политических предпочтений в обществе.

— Использование технологий Big Data актуально для решений класса гарантирования доходов (RA), которые включают в себя инструменты обнаружения несоответствий и углубленного анализа данных, позволяющие своевременно выявить вероятные потери, либо искажения информации, способные привести к снижению финансовых результатов.

— Телекоммуникационные провайдеры могут агрегировать большие данные, в том числе о геолокации; в свою очередь эта информация может представлять коммерческий интерес для рекламных агентств, которые могут использовать ее для показа таргетированной и локальной рекламы, а также для ритейлеров и банков.

— Большие данные могут сыграть важную роль при решении открытия торговой точки в определенной локации на основе данных о наличии мощного целевого потока людей.

Таким образом наиболее очевидное практическое применение технологии Big Data лежит в сфере маркетинга. Благодаря развитию интернета и распространению всевозможных коммуникационных устройств поведенческие данные (такие как число звонков, покупательские привычки и покупки) становятся доступными в режиме реального времени.

Технологии больших данных могут также эффективно использоваться в финансах, для социологических исследований и во многих других сферах. Эксперты утверждают, что все эти возможности использования больших данных являются лишь видимой частью айсберга, поскольку в гораздо больших объемах эти технологии используются в разведке и контрразведке, в военном деле, а также во всем том, что принято называть информационными войнами.

В общих чертах последовательность работы с Big Data состоит из сбора данных, структурирования полученной информации с помощью отчетов и дашбордов, а также последующего формулирования рекомендаций к действию.

Рассмотрим вкратце возможности использования технологий Big Data в маркетинге. Как известно, для маркетолога информация – главный инструмент для прогнозирования и составления стратегии. Анализ больших данных давно и успешно применяется для определения целевой аудитории, интересов, спроса и активности потребителей. Анализ больших данных, в частности, позволяет выводить рекламу (на основе модели RTB-аукциона — Real Time Bidding) только тем потребителям, которые заинтересованы в товаре или услуге.

Применение Big Data в маркетинге позволяет бизнесменам:

— лучше узнавать своих потребителей, привлекать аналогичную аудиторию в Интернете;

— оценивать степень удовлетворенности клиентов;

— понимать, соответствует ли предлагаемый сервис ожиданиям и потребностям;

— находить и внедрять новые способы, увеличивающие доверие клиентов;

— создавать проекты, пользующиеся спросом и т. д.

Например, сервис Google.trends может указать маркетологу прогноз сезонной активности спроса на конкретный продукт, колебания и географию кликов. Если сопоставить эти сведения со статистическими данными, собираемыми соответствующим плагином на собственном сайте, то можно составить план по распределению рекламного бюджета с указанием месяца, региона и других параметров.

По мнению многих исследователей, именно в сегментации и использовании Big Data заключается успех предвыборной кампании Трампа. Команда будущего президента США смогла правильно разделить аудиторию, понять ее желания и показывать именно тот месседж, который избиратели хотят видеть и слышать. Так, по мнению Ирины Белышевой из компании Data-Centric Alliance, победа Трампа во многом стала возможной благодаря нестандартному подходу к интернет-маркетингу, в основу которого легли Big Data, психолого-поведенческий анализ и персонализированная реклама.

Политтехнологи и маркетологи Трампа использовали специально разработанную математическую модель, которая позволила глубоко проанализировать данные всех избирателей США систематизировать их, сделав сверхточный таргетинг не только по географическим признаками, но также и по намерениям, интересам избирателей, их психотипу, поведенческим характеристикам и т. д. После этого маркетологи организовали персонализированную коммуникацию с каждой из групп граждан на основе их потребностей, настроений, политических взглядов, психологических особенностей и даже цвета кожи, используя практически для каждого отдельного избирателя свой месседж.

Что касается Хиллари Клинтон, то она в своей кампании использовала «проверенные временем» методы, основанные на социологических данных и стандартном маркетинге, разделив электорат лишь на формально гомогенные группы (мужчины, женщины, афроамериканцы, латиноамериканцы, бедные, богатые и т. д.).

В результате выиграл тот, кто по достоинству оценил потенциал новых технологий и методов анализа. Примечательно, что расходы на предвыборную кампанию Хиллари Клинтон были в два раза больше, чем у ее оппонента:

Данные: Pew Research

Основные проблемы использования Big Data

Помимо высокой стоимости, одним из главных факторов, тормозящих внедрение Big Data в различные сферы, является проблема выбора обрабатываемых данных: то есть определения того, какие данные необходимо извлекать, хранить и анализировать, а какие – не принимать во внимание.

Еще одна проблема Big Data носит этический характер. Другими словами возникает закономерный вопрос: можно ли подобный сбор данных (особенно без ведома пользователя) считать нарушением границ частной жизни?

Не секрет, что информация, сохраняемая в поисковых системах Google и Яндекс, позволяет IT-гигантам постоянно дорабатывать свои сервисы, делать их удобными для пользователей и создавать новые интерактивные приложения. Для этого поисковики собирают пользовательские данные об активности пользователей в интернете, IP-адреса, данные о геолокации, интересах и онлайн-покупках, личные данные, почтовые сообщения и т. д. Все это позволяет демонстрировать контекстную рекламу в соответствии с поведением пользователя в интернете. При этом обычно согласия пользователей на это не спрашивается, а возможности выбора, какие сведения о себе предоставлять, не дается. То есть по умолчанию в Big Data собирается все, что затем будет храниться на серверах данных сайтов.

Из этого вытекает следующая важная проблема, касающаяся обеспечения безопасности хранения и использования данных. Например, безопасна ли та или иная аналитическая платформа, которой потребители в автоматическом режиме передают свои данные? Кроме того, многие представители бизнеса отмечают дефицит высококвалифицированных аналитиков и маркетологов, способных эффективно оперировать большими объемами данных и решать с их помощью конкретные бизнес-задачи.

Несмотря на все сложности с внедрением Big Data, бизнес намерен увеличивать вложения в это направление. По данным исследования Gartner, лидерами инвестирующих в Big Data отраслей являются медиа, ритейл, телеком, банковский сектор и сервисные компании.

Перспективы взаимодействия технологий блокчейн и Big Data

Интеграция технологии распределенного реестра с Big Data несет в себе синергетический эффект и открывает бизнесу широкий спектр новых возможностей, в том числе позволяя:

— получать доступ к детализированной информации о потребительских предпочтениях, на основе которых можно выстраивать подробные аналитические профили для конкретных поставщиков, товаров и компонентов продукта;

— интегрировать подробные данные о транзакциях и статистике потребления определенных групп товаров различными категориями пользователей;

— получать подробные аналитические данные о цепях поставок и потребления, контролировать потери продукции при транспортировке (например, потери веса вследствие усыхания и испарения некоторых видов товаров);

— противодействовать фальсификациям продукции, повысить эффективность борьбы с отмыванием денег и мошенничеством и т. д.

Доступ к подробным данным об использовании и потреблении товаров в значительной мере раскроет потенциал технологии Big Data для оптимизации ключевых бизнес-процессов, снизит регуляторные риски, раскроет новые возможности монетизации и создания продукции, которая будет максимально соответствовать актуальным потребительским предпочтениям.

Как известно, к технологии блокчейн уже проявляют значительный интерес представители крупнейших финансовых институтов, включая Citibank, Nasdaq, Visa и т. д. По мнению Оливера Буссманна, IT-менеджера швейцарского финансового холдинга UBS, технология блокчейн способна «сократить время обработки транзакций от нескольких дней до нескольких минут».

Потенциал анализа финансовой информации из блокчейна при помощи технологии Big Data огромен. Технология распределенного реестра обеспечивает целостность информации, а также надежное и прозрачное хранение всей истории транзакций. Big Data, в свою очередь, предоставляет новые инструменты для эффективного анализа, прогнозирования, экономического моделирования и, соответственно, открывает новые возможности для принятия более взвешенных управленческих решений.

Тандем блокчейна и Big Data можно успешно использовать в здравоохранении. Как известно, несовершенные и неполные данные о здоровье пациента в разы увеличивают риск постановки неверного диагноза и неправильно назначенного лечения. Критически важные данные о здоровье клиентов медучреждений должны быть максимально защищенными, обладать свойствами неизменности, быть проверяемыми и не должны быть подвержены каким-либо манипуляциям.

Информация в блокчейне соответствует всем перечисленным требованиям и может служить в роли качественных и надежных исходных данных для глубокого анализа при помощи новых технологий Big Data. Помимо этого, при помощи блокчейна медицинские учреждения смогли бы обмениваться достоверными данными со страховыми компаниями, органами правосудия, работодателями, научными учреждениями и другими организациями, нуждающимися в медицинской информации.

Big Data и информационная безопасность

В широком понимании, информационная безопасность представляет собой защищенность информации и поддерживающей инфраструктуры от случайных или преднамеренных негативных воздействий естественного или искусственного характера.

В области информационной безопасности Big Data сталкивается со следующими вызовами:

— проблемы защиты данных и обеспечения их целостности;

— риск постороннего вмешательства и утечки конфиденциальной информации;

— ненадлежащее хранение конфиденциальной информации;

— риск потери информации, например, вследствие чьих-либо злонамеренных действий;

— риск нецелевого использования персональных данных третьими лицами и т. д.

Одна из главных проблем больших данных, которую призван решить блокчейн, лежит в сфере информационной безопасности. Обеспечивая соблюдение всех основных ее принципов, технология распределенного реестра может гарантировать целостность и достоверность данных, а благодаря отсутствию единой точки отказа, блокчейн делает стабильной работу информационных систем. Технология распределенного реестра может помочь решить проблему доверия к данным, а также предоставить возможность универсального обмена ими.

Информация – ценный актив, а это значит, что на первом плане должен стоять вопрос обеспечения основных аспектов информационной безопасности. Для того, чтобы выстоять в конкурентной борьбе, компании должны идти в ногу со временем, а это значит, что им нельзя игнорировать те потенциальные возможности и преимущества, которые заключают в себе технология блокчейн и инструменты Big Data.

http://www.itsec.ru/articles/primenenie-instrumentov-big-data-i-machine-learning-v-iot

https://forklog.com/big-data-i-blokchejn-proryv-v-oblasti-analiza-dannyh/